解放军某疗养院PACS系统高可用应用

方案背景

解放军某疗养院为我军级别最高、规模最大的疗养院,是军队各级首长和地方各界朋友健康体检、养生保健、康复疗养基地。

疗养院体检中心,配备美国GE彩色B超、菲利浦数字化摄片(DR)、GE螺旋CT、GE磁共振、热CT成像系统。日立全自动生化分析仪、多肿瘤标志物蛋白芯片检测系统等高档仪器,集结了当今国际最先进的PACS医学影像传输系统、LIS检验信息系统、自动排队等候系统等信息化健康体检管理系统。

PACS系统现状

采用主服务器部署PACS系统,PACS系统的数据采用服务器自带硬盘进行存储,服务器硬盘采用RAID5的方式保护数据安全。

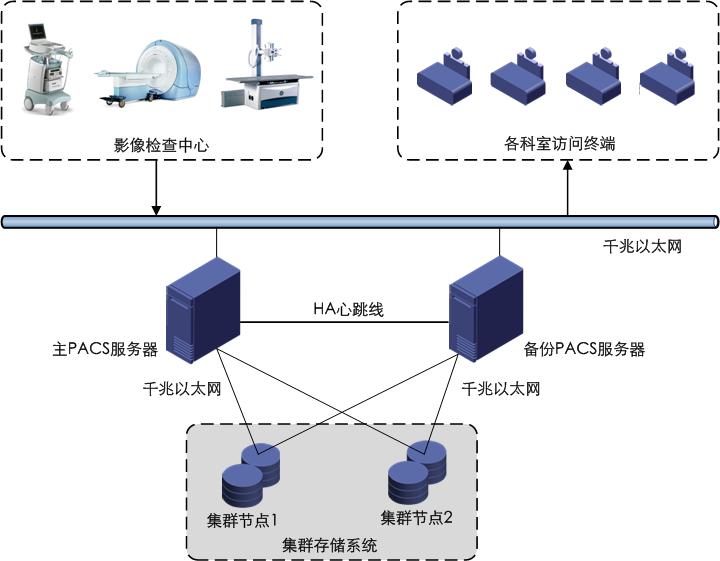

配置一台备份服务器,定期进行数据备份,当主服务器宕机时,需人工干预,启动备份服务器来继续PACS系统的运行。如下图所示:

随着疗养院就诊人数的不断增加及医学影像对数字化精度的不断提高,PACS系统的工作及存储压力愈来愈大。

存储量倍增,服务器自带的硬盘存储空间无法满足海量PACS数据存储的容量要求;

服务器多块硬盘故障引起的RAID组失效,必将造成PACS系统数据的丢失,存储系统可靠性差;

主服务器定期向备份服务器备份的方式,无法保证备份数据的完整性;

两台服务器无双机热备机制,服务器宕机需要人工干预,业务连续性差。

面临这些问题,该疗养院急需上线一套高可用的PACS系统,来保证业务的连续性和高可靠性。

系统建设需求

建设单独的存储系统,完成PACS海量数据的存储;

存储系统需具备高可用性,不能因为硬盘或存储设备的故障造成PACS系统的业务中断;

原PACS系统服务器利旧使用,建设成主备的方式,当一台服务器出现故障时,另一台服务器自动实现业务切换,无需人工干预,保证PACS系统业务的连续性。

解决方案

鲸鲨根据解放军某疗养院对PACS系统的需求,采用IBRICK集群存储构建存储子系统。服务器采用双机热备的方式保证业务连续性。如下图所示:

1) 服务器双机热备部署

两台PACS服务器均部署RoseHA软件,实双机热备,热备模式为:Active/Standby。两台服务器之间通过私用心跳网络连接,通过RoseHA软件监控系统运行状态,当主服务器发生故障时,RoseHA就会控制系统自动切换至备用服务器,保证PACS系统的业务不中断。

2) 集群存储系统部署

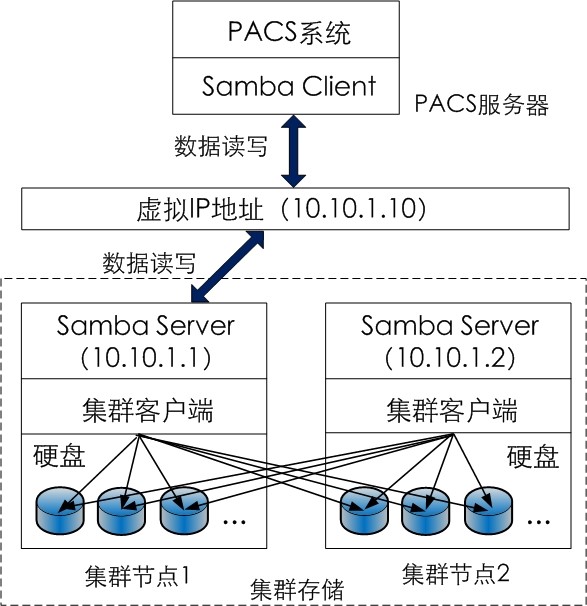

集群存储由两个节点组成,采用双机镜像的方式保障数据安全,并提供单一IP的samba访问接口。PACS系统通过samba客户端访问集群存储系统中的一个节点,当所访问的节点发生故障时,服务能迅速切换到另一个节点上,保证PACS系统业务不中断。整个过程对上层透明,对系统使用没有影响。

iBRICK集群存储采用分布式全对称集群文件系统,对两个节点的数据实时同步,保障数据安全;节点中的硬盘或单一节点出现故障时,数据不丢失。通过任意节点上的集群客户端都可以访问到两个节点上的所有数据。

通过配置CTDB,把两个集群节点的物理IP隐藏于虚拟IP之后,PACS系统通过这个虚拟IP来访问集群存储,由CTDB把虚拟IP映射为其中一个集群节点的物理IP。如下图所示:

高可用设计

磁盘故障时的读操作:

每台集群节点的磁盘在另一个节点上都有镜像,通过集群客户端能直接访问到该镜像,当单块磁盘故障时读操作可以正常运行。

磁盘故障时的写操作:

PACS系统每次写操作都会同时向两块磁盘发起数据写入,只要其中一块磁盘写入成功,整个写操作就会成功。磁盘故障造成的数据损坏(丢失)会在更换新磁盘后自行修复。

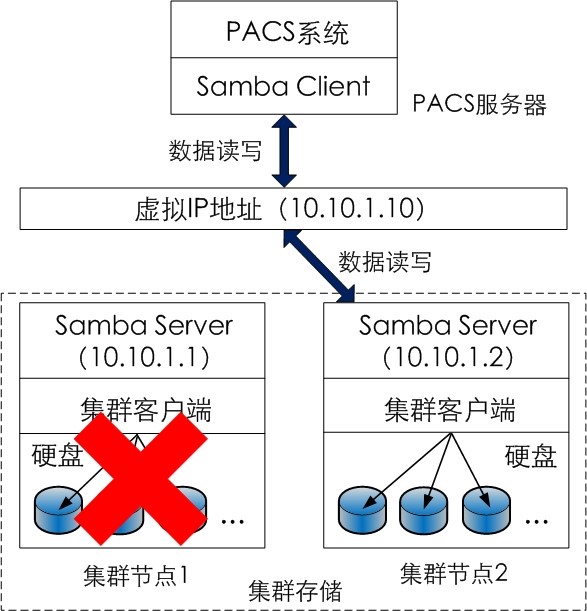

网络或集群节点故障:

当PACS系统正在访问的集群节点发生网络或节点故障时,CTDB会迅速侦测到该故障,并把虚拟IP映射到另一台可正常工作的节点上,PACS系统仍然能正常工作,业务不中断。如下图所示:

性能设计

集群存储系统通过两个节点同时存取数据的方法以满足PACS服务器的访问需求。PACS服务器对集群存储空间的访问通过每个节点上独立接口进行。大量的数据IO请求都被分散到两个集群节点上,全面的负载均衡策略使每个节点的磁盘性能和网络带宽都可以得到充分的利用;

鲸鲨集群存储采用千兆网络进行部署,每节点配置4个GbE接口,采用网卡绑定技术,集群系统可提供300MB/s以上的带宽性能,满足疗养院PACS系统数据读写的性能需求。

容量设计

鲸鲨为该疗养院每节点配置了8块2TB的SATAIII企业级磁盘,磁盘镜像后可提供16TB的存储空间,满足了PACS系统对存储容量的需求;

单节点支持24个磁盘位,最大支持96TB的裸容量,随着疗养院PACS系统数据量的不断提升,可采用增加硬盘的方式进行扩容;

集群存储系统支持Scale-out横向扩展,增加集群节点,容量和性能同时线性提升。

客户受益

鲸鲨软件为解放军某疗养院PACS系统部署了高可用的服务器双机热备和集群存储解决方案,在满足了PACS系统对数据存储大容量、高性能要求的同时,也为用户带来了系统的高可用性,另外,存储系统的集群化部署,后期扩展方便,保护用户投资。